Nobel de Física conquistado por pioneiros da aprendizagem de máquina

John Hopfield e Geoffrey Hinton foram pioneiros em métodos computacionais que permitiram o desenvolvimento de redes neurais.

Dois pesquisadores que desenvolveram ferramentas para entender as redes neurais que sustentam o atual crescimento da inteligência artificial (IA) ganharam o Prêmio Nobel de Física de 2024.

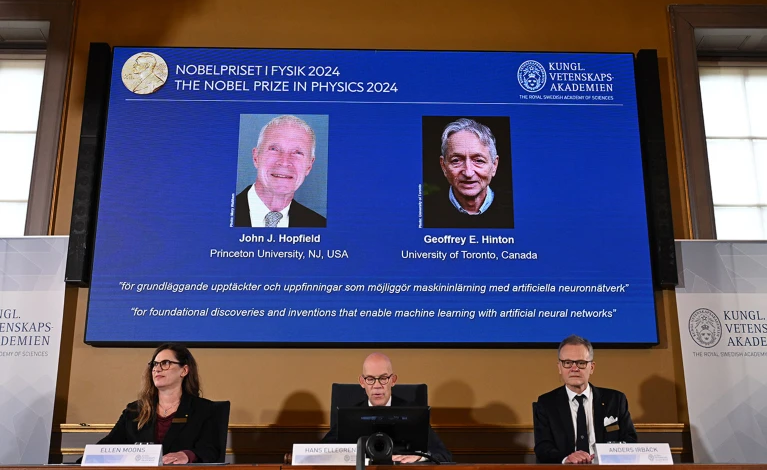

John Hopfield, da Universidade de Princeton, em Nova Jersey, e Geoffrey Hinton, da Universidade de Toronto, Canadá, dividem o prêmio de 11 milhões de coroas suecas (US$ 1 milhão), anunciado pela Real Academia Sueca de Ciências, em Estocolmo, em 8 de outubro.

Ambos usaram ferramentas da física para criar métodos que alimentam redes neurais artificiais , que exploram estruturas em camadas inspiradas no cérebro para aprender conceitos abstratos. Suas descobertas “formam os blocos de construção do aprendizado de máquina , que podem ajudar os humanos a tomar decisões mais rápidas e confiáveis”, disse a presidente do comitê do Nobel, Ellen Moons, uma física da Universidade de Karlstad, Suécia, durante o anúncio. “Redes neurais artificiais têm sido usadas para avançar a pesquisa em tópicos de física tão diversos quanto física de partículas, ciência de materiais e astrofísica.”

Memória da máquina

Em 1982, Hopfield, um biólogo teórico com formação em física, criou uma rede que descrevia conexões entre neurônios virtuais como forças físicas 1 . Ao armazenar padrões como um estado de baixa energia da rede, o sistema poderia recriar o padrão quando solicitado com algo semelhante. Tornou-se conhecido como memória associativa, porque a maneira como ela “lembra” coisas é semelhante ao cérebro tentando lembrar uma palavra ou conceito com base em informações relacionadas.

Hinton, um cientista da computação, usou princípios da física estatística, que descreve coletivamente sistemas que têm muitas partes para rastrear individualmente, para desenvolver ainda mais a ‘rede Hopfield’. Ao construir probabilidades em uma versão em camadas da rede, ele criou uma ferramenta que podia reconhecer e classificar imagens, ou gerar novos exemplos do tipo em que foi treinada 2 .

Esses processos diferiam de tipos anteriores de computação, pois as redes eram capazes de aprender com exemplos, incluindo dados complexos. Isso teria sido desafiador para softwares convencionais dependentes de cálculos passo a passo.

As redes são “modelos grosseiramente idealizados que são tão diferentes das redes neurais biológicas reais quanto maçãs são dos planetas”, escreveu Hinton na Nature Neuroscience em 2000. Mas elas se mostraram úteis e foram amplamente desenvolvidas. Redes neurais que imitam o aprendizado humano formam a base de muitas ferramentas de IA de última geração, desde modelos de linguagem grandes (LLMs) até algoritmos de aprendizado de máquina capazes de analisar grandes faixas de dados, incluindo o modelo de predição de estrutura de proteína AlphaFold .

Falando por telefone no anúncio, Hinton disse que saber que havia ganhado o Nobel foi “um raio do nada”. “Estou pasmo, não tinha ideia de que isso aconteceria”, disse ele. Ele acrescentou que os avanços no aprendizado de máquina “terão uma influência enorme, será comparável à revolução industrial. Mas, em vez de exceder as pessoas em força física, excederá as pessoas em capacidade intelectual”.

Nos últimos anos, Hinton se tornou uma das vozes mais altas pedindo que salvaguardas fossem colocadas em torno da IA. Ele diz que se convenceu no ano passado de que a computação digital havia se tornado melhor do que o cérebro humano, graças à sua capacidade de compartilhar o aprendizado de várias cópias de um algoritmo, rodando em paralelo. “Até aquele ponto, eu passei 50 anos pensando que se pudéssemos torná-lo mais parecido com o cérebro, ele seria melhor”, disse ele em 31 de maio, falando virtualmente para o AI for Good Global Summit em Genebra, Suíça. “Isso me fez pensar que [esses sistemas] vão se tornar mais inteligentes do que nós mais cedo do que eu pensava.”

Motivado pela física

Hinton também ganhou o Prêmio Alan Turing em 2018 — às vezes descrito como o “Nobel da ciência da computação” . Hopfield também ganhou vários outros prêmios de física de prestígio, incluindo a Medalha Dirac.

“[A motivação de Hopfield] era realmente física, e ele inventou esse modelo de física para entender certas fases da matéria”, diz Karl Jansen, um físico do laboratório alemão Electron Synchrotron (DESY) em Zeuthen, que descreve o trabalho como “inovador”. Após décadas de desenvolvimentos, as redes neurais se tornaram uma ferramenta importante na análise de dados de experimentos de física e na compreensão dos tipos de transições de fase que Hopfield havia se proposto a estudar, acrescenta Jansen.

Lenka Zdeborová, especialista em física estatística da computação no Instituto Federal Suíço de Tecnologia em Lausanne (EPFL), diz que ficou agradavelmente surpresa que o Comitê Nobel reconheceu a importância das ideias da física para entender sistemas complexos. “Essa é uma ideia muito genérica, seja de moléculas ou pessoas na sociedade.”

Nos últimos cinco anos, o Prêmio Abel e as Medalhas Fields também celebraram a fertilização cruzada entre matemática, física e ciência da computação , particularmente as contribuições para a física estatística.

Ambos os vencedores “trouxeram ideias incrivelmente importantes da física para a IA”, diz Yoshua Bengio, um cientista da computação que dividiu o Prêmio Turing de 2018 com Hinton e seu colega pioneiro em redes neurais Yann LeCun. O trabalho seminal e o entusiasmo contagiante de Hinton fizeram dele um grande modelo para Bengio e outros proponentes iniciais de redes neurais. “Isso me inspirou incrivelmente quando eu era apenas um estudante universitário”, diz Bengio, que é diretor do Instituto de Algoritmos de Aprendizagem de Montreal no Canadá. Muitos cientistas da computação consideraram a rede neural infrutífera por décadas, diz Bengio — um grande ponto de virada foi quando Hinton e outros a usaram para vencer uma grande competição de reconhecimento de imagem em 2012.

Benefícios do modelo cerebral

A biologia também se beneficiou desses modelos artificiais do cérebro. May-Britt Moser, neurocientista da Universidade Norueguesa de Ciência e Tecnologia em Trondheim e ganhadora do Prêmio Nobel de Fisiologia ou Medicina de 2014 , diz que ficou “tão feliz” quando viu os vencedores anunciados. Versões dos modelos de rede de Hopfield têm sido úteis para neurocientistas, ela diz, ao investigar como os neurônios trabalham juntos na memória e na navegação. Seu modelo, que descreve memórias como pontos baixos de uma superfície, ajuda os pesquisadores a visualizar como certos pensamentos ou ansiedades podem ser fixados e recuperados no cérebro, ela acrescenta. “Adoro usar isso como uma metáfora para falar com as pessoas quando elas estão presas.”

Hoje, a neurociência depende de teorias de rede e ferramentas de aprendizado de máquina, que surgiram do trabalho de Hopfield e Hinton, para entender e processar dados em milhares de células simultaneamente, diz Moser. “É como um combustível para entender coisas que nem podíamos sonhar quando começamos neste campo”.

“O uso de ferramentas de machine learning está tendo um impacto imensurável na análise de dados e em nossa compreensão potencial de como os circuitos cerebrais podem computar”, diz Eve Marder, neurocientista da Brandeis University em Waltham, Massachusetts. “Mas esses impactos são ofuscados pelos muitos impactos que o machine learning e a inteligência artificial estão tendo em todos os aspectos de nossas vidas diárias.”

Fonte: Nature